Inteligência Artificial em Teleconferências: Processamento de Imagem para Acompanhamento de Expressões Faciais

A Revista Eletrônica PesquisABC possui o seguinte registro ISSN: 2675-1461

Murilo de Souza Pretoa*, Fernando Teubl Ferreirab, Celso Setsuo Kurashimac

a Discente do Bacharelado em Ciência e Tecnologia, Universidade Federal do ABC

b Docente do Centro de Matemática Computação e Cognição, Universidade Federal do ABC

c Docente do Centro de Engenharia, Modelagem e Ciências Sociais Aplicadas, Universidade Federal do ABC

Resumo: Este trabalho desenvolveu uma solução baseada em inteligência artificial (IA) para aumentar o engajamento de alunos no ensino a distância (EaD), abordando a falta de comunicação não verbal como principal desafio. Um sistema integrado foi projetado para reconhecer expressões faciais em tempo real, utilizando câmeras comuns e analisando dados em servidores centralizados. Professores podem acessar gráficos de engajamento via interface web. Após um levantamento de métodos de Reconhecimento de Expressões Faciais (REF), implementaram-se etapas de pré-processamento de imagens, incluindo extração de região de interesse e alinhamento facial. Modelos de IA, como Residual Masking Network e DeepFace, foram testados em bases de dados CK+ e AffectNet, apresentando acurácia média de 83,6% em condições controladas e 57,6% em cenários desafiadores. O tempo médio de processamento variou entre 0,35s e 0,65s, comprovando a viabilidade prática do sistema em diferentes plataformas. A infraestrutura inclui servidores interconectados que suportam a coleta e exibição de dados em tempo real. A solução representa um avanço na integração de IA no EaD, permitindo maior adaptação às necessidades dos alunos e promovendo ambientes de aprendizado mais eficazes. Testes indicam robustez e potencial para ampliar o uso da tecnologia em diversos contextos educacionais.

Palavras-chave: reconhecimento de expressões faciais; inteligência artificial; ensino a distância; engajamento de alunos; processamento de imagens; comunicação não verbal.

Abstract: This study developed an artificial intelligence-based solution to enhance student engagement in distance education, addressing the lack of nonverbal communication as a key challenge. An integrated system was designed to recognize facial expressions in real-time using standard cameras, with data processed on centralized servers. Teachers can access engagement metrics through a web interface, enabling them to adapt their teaching strategies effectively. After a comprehensive review of methods for facial expression recognition, the study implemented image preprocessing steps, including region-of-interest extraction and facial alignment. Artificial intelligence models, such as the Residual Masking Network and DeepFace, were tested using the CK+ and AffectNet datasets, achieving an average accuracy of 83.6% in controlled conditions and 57.6% in more challenging scenarios. The average processing time ranged from 0.35 to 0.65 seconds, demonstrating the system's practical viability across different computing platforms. The system infrastructure includes interconnected servers that facilitate real-time data collection and visualization. This solution represents an application of artificial intelligence in distance learning, allowing teachers to respond more effectively to student needs and fostering more engaging and productive learning environments. Tests confirmed the system's robustness and its potential for broader adoption in educational settings.

Keywords: facial expression recognition; artificial intelligence; distance learning; student engagement; image processing; nonverbal communication.

https://orcid.org/0009-0003-5867-7882

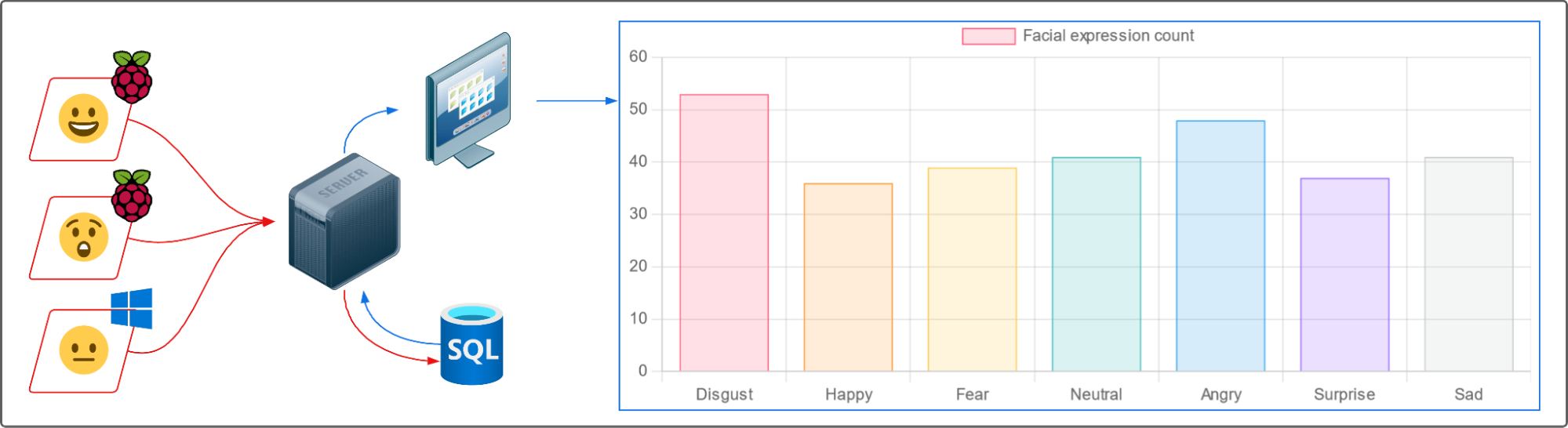

Visão geral: Resumo de tudo que foi feito

Figura 1: Visão geral do sistema. Pode-se observar, lendo da esquerda para direita, o fluxo de funcionamento do sistema. A partir de um computador e uma câmera, a expressão facial de um aluno é avaliada em tempo real e a informação é enviada para uma central de servidores, na qual um professor pode acompanhar gráficos de engajamento obtidos através da compilação das expressões faciais dos alunos.

Introdução: Contexto no qual o trabalho foi desenvolvido e objetivo da pesquisa

A pandemia de COVID-19 trouxe desafios significativos, especialmente para atividades que dependiam da interação presencial. Isso impactou profundamente nas rotinas de trabalho e estudo, levando a um aumento no uso de tecnologias de teleconferência [1]. Desde então, videochamadas se tornaram parte do dia a dia de muitas pessoas, principalmente com a consolidação do home office para diversas profissões [2].

No entanto, o ensino a distância (EaD) apresenta desafios importantes, como a queda no engajamento dos alunos. Entre os fatores identificados, destacou-se a ausência de comunicação não verbal, essencial para uma interação mais efetiva [3].

Diante dessa problemática, este estudo investigou a viabilidade de utilizar modelos de inteligência artificial (IA), treinados para o Reconhecimento de Expressões Faciais (REF), em plataformas de videochamada. O objetivo principal foi avaliar se era possível detectar em tempo real as expressões faciais dos alunos e utilizá-las como métricas em uma plataforma centralizada, permitindo que professores recebessem esses dados em tempo real e, assim, melhorassem a interação e o engajamento nas aulas.

Metodologia da Pesquisa: Como o estudo foi conduzido

As etapas principais do trabalho incluíram:

1. Estudo e levantamento de métodos de REF – Estudamos como os principais métodos de Reconhecimento de Faces e Reconhecimento de Expressões Faciais funcionam. Escolhemos as inteligências artificiais (IA) mais promissoras para serem testadas;

2. Preparação de imagens para análise – Desenvolvemos um processo para organizar e ajustar as imagens (pré-processamento) antes de enviá-las para análise pela inteligência artificial. Isso ajuda a IA a trabalhar mais rápido e de forma mais precisa, reduzindo erros na identificação das expressões faciais;

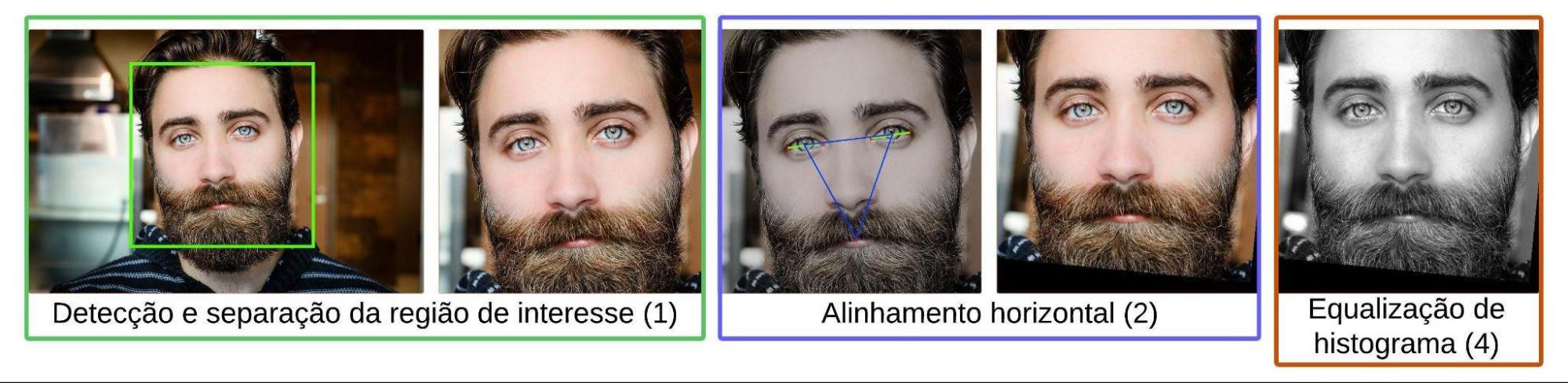

Figura 2: Etapas de pré-processamento da captura facial. Imagem do modelo disponível em domínio público [4], processamento e diagrama realizados pelo autor.

1. Testes em bancos de imagens – Utilizamos coleções de imagens que já possuíam as expressões faciais identificadas como referência (imagens catalogadas). Enviamos essas imagens para a IA analisar e depois comparamos os resultados dela com os registros originais, verificando sua acurácia e tempo de processamento;

2. Criação de uma aplicação prática – Escolhemos a IA que apresentou os melhores resultados nos testes e a adaptamos para funcionar com imagens capturadas em tempo real, usando uma câmera comum. Assim, foi possível aplicar a tecnologia em situações reais;

3. Construção de um banco de dados e interface gráfica – Projetamos um sistema para organizar as expressões faciais detectadas pela IA e exibi-las de forma simples. Criamos gráficos que mostram essas informações em tempo real para os professores, por meio de uma página na internet fácil de usar.

Com base nesses passos, foi desenvolvida a plataforma Central para Reconhecimento de Expressões Faciais. Por meio dessa ferramenta, professores podem monitorar métricas de engajamento dos alunos apresentadas em gráficos em tempo real, com base nas expressões faciais detectadas durante as videochamadas.

Resultados e Conclusões: O que descobrimos com o estudo

Os testes realizados demonstraram a viabilidade da aplicação. O sistema foi capaz de detectar expressões faciais em tempo real, com tempos médios de resposta variando entre 0,35 segundos e 0,65 segundos, dependendo da capacidade de processamento do computador utilizado. Ademais, o sistema detectou com uma acurácia média – isto é, o detector acertou a expressão facial – de 83,6% de acertos em boas condições (imagens obtidas em laboratório com boa iluminação e posição do rosto) e 57,6% em condições desafiadoras (imagens obtidas em condições variadas). Esses resultados atestam a viabilidade da proposta e reforçam o potencial do uso de IA para aprimorar o ensino a distância.

A Central para Reconhecimento de Expressões Faciais representa uma solução para um dos maiores desafios do EaD: a falta de comunicação não-verbal. Com a aplicação desta tecnologia, espera-se que professores possam adaptar suas estratégias de ensino com base em indicadores concretos, promovendo um ambiente de aprendizado mais eficaz e engajador para os alunos.

Aprofundamento do trabalho realizado

Materiais utilizados ao longo do projeto

Modelos de Inteligência Artificial

Modelos utilizados para o pré-processamento de imagens:

- OpenCV [5] - Detecção facial (Modelo de Cascata em Haar) e Equalização de Histograma;

- DLIB [6] - Alinhamento horizontal (Modelo de detecção de características faciais em três pontos);

Modelos utilizados, testados e documentados para Reconhecimento de Expressões Faciais:

- Residual Masking Network [7] - Modelo de detecção facial convolucional baseado em máscaras residuais. Foi documentado como o modelo ideal para o caso do projeto, apresentando a maior acurácia dentre os testados, porém tempo de processamento comparativamente alto.

- DeepFace [8] - Modelo de detecção geral com capacidade para detecção de expressões faciais. Foi testado como uma boa alternativa para sistemas de baixa capacidade de processamento, por exemplo, como um Raspberry Pi 4B. Alta frequência de detecção, mas baixa acurácia.

Máquinas

Computadores utilizados para testes:

- Computador com alta capacidade de processamento, utilizado do laboratório NAVI3, Campus de São Bernardo do Campo, da Universidade Federal do ABC: OS Windows 11, x64 Processor, Intel® Core™ i7-4790 CPU 3.60 GHz, 16 GB RAM;

- Computador com média capacidade de processamento: OS Windows 10, AMD Ryzen 5 1400 Quad-Core CPU 3.20 GHz, 16 GB RAM;

- Notebook com média capacidade de processamento: OS Linux Mint 21.1 Cinnamon, Intel Core i5-7200U CPU 2.50GHz × 2, 8 GB RAM;

- Raspberry Pi (baixa capacidade de processamento) [9]: OS Raspberry Pi Full, 64 bits, system model 4B, Broadcom BCM2711 Quad core Cortex-A72 (ARM v8) 64-bit SoC 1.8GHz, 1 GB RAM.

Bases de dados

As principais métricas adotadas para avaliar as IAs selecionadas para o REF foram acurácia e tempo de processamento. Para a acurácia, foi priorizado o acerto de detecções de felicidade e expressão facial neutra. Para o tempo de processamento, foi definido o limiar de corte de mediana máxima de tempo de processamento de um (1) segundo por detecção.

Nesses critérios, foram utilizadas as bases de dados Extended Cohn-Kanade Dataset [10] (CK+) e AffectNet [11] para testar os modelos. A base de dados CK+ apresenta imagens capturadas em laboratório em boas condições de iluminação e posicionamento facial, enquanto que a AffectNet apresenta imagens capturadas em condições variadas e desafiadoras (variação da posição e rotação de rostos, assim como iluminação não-controlada). Ambas as bases de dados são anotadas (apresentam imagens de rostos com a respectiva expressão facial indicada) e contém imagens de pessoas de variadas idades e etnias.

Pré-processamento de imagens

A princípio, o levantamento de Li & Deng [12] foi tomado como ponto de partida para o estudo de técnicas de pré-processamento e processamento de imagem. Assim como é citado no artigo, foram testadas as etapas de:

- Extração da região de interesse - Consiste em detectar as faces presentes em uma imagem e separá-las para processamento individual, em vez de processar a imagem inteira (Esse conceito é popularmente conhecido como Region Of Interest - ROI);

- Alinhamento facial - Através de informações de simetria da face humana, por exemplo, a linha formada entre os lábios, pode-se determinar se o rosto está inclinado em uma determinada angulação em relação à reta horizontal. Com essa informação, um rosto detectado pode ser rotacionado a fim de alinhar a reta formada pelos lábios com a horizontal, padronizando as imagens;

- Frontalização - De forma similar ao alinhamento, a frontalização consiste em rotacionar um rosto em torno do eixo vertical. Por exemplo, fazer com que um rosto virado para o lado aponte para a frente. Todavia, esse método é generativo e faz uso de extrapolação de simetrias faciais para frontalizar um rosto e, portanto, deve ser amplamente testado para verificar se houve ganho na sua utilização;

- Equalização de iluminação - A equalização de iluminação é a etapa final, mas a mais simples. Ela consiste em distribuir a iluminação de uma imagem ao longo do espectro comportado em sua resolução, sendo útil para corrigir artefatos luminosos em imagens capturadas com uma exposição luminosa muito alta ou muito baixa. Isso pode ser feito através da equalização do histograma que representa a intensidade luminosa.

Durante a fase inicial de testes, notou-se o principal ganho de eficiência ao empregar a Extração de Região de Interesse (1), e o segundo maior ganho ao utilizar o Alinhamento Facial (2). A etapa de Frontalização (3) não foi utilizada por não representar ganho nas condições esperadas de funcionamento do sistema. A Equalização de Histograma (4) foi implementada no sistema mas, posteriormente, foi desabilitada pois notou-se que os casos de utilização que apresentavam ganho com a etapa adicional eram raros.

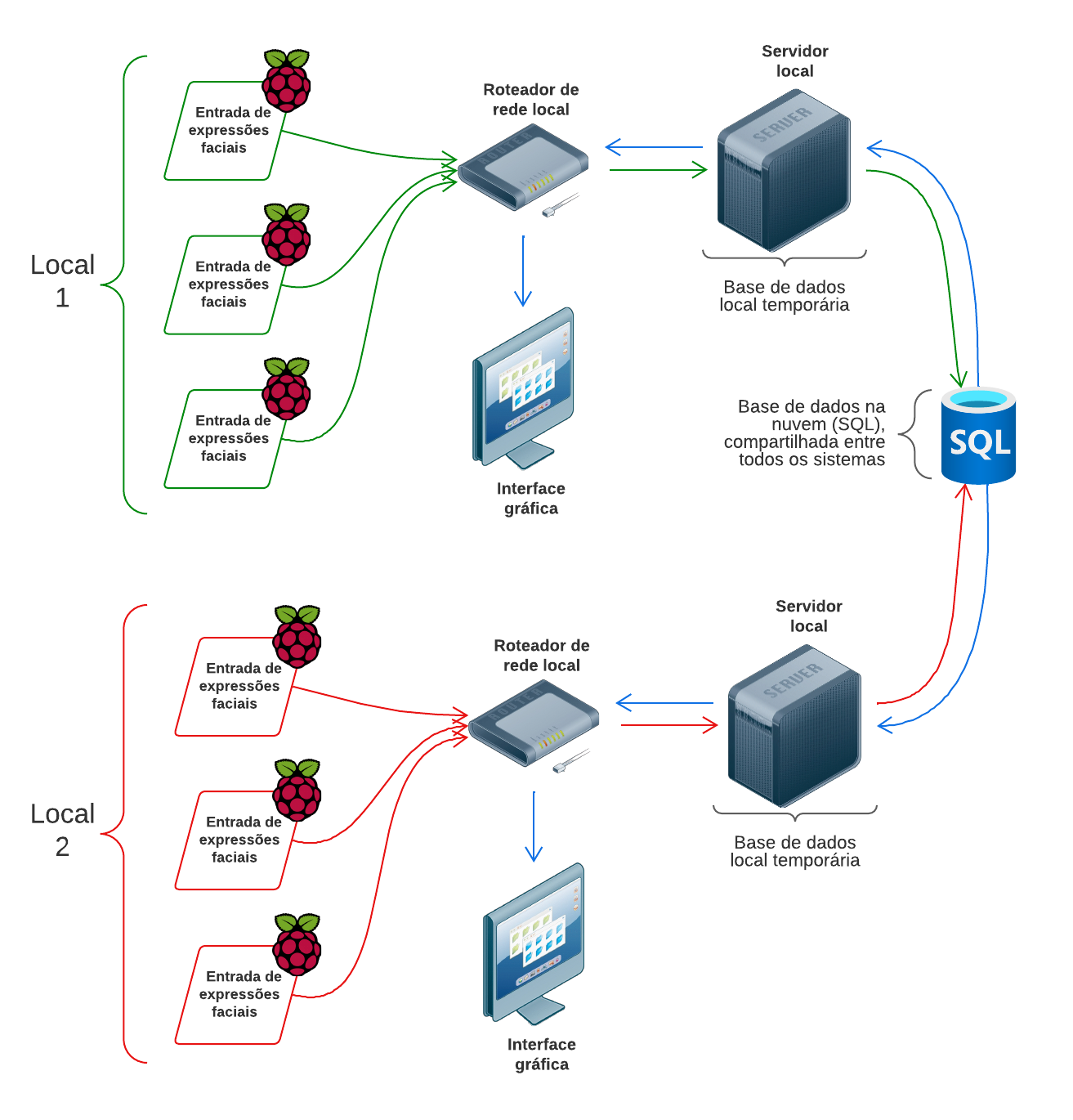

Arquitetura de servidores

Uma parte considerável do projeto abarcou testar diferentes arquiteturas de servidores para a hospedagem do sistema. Dentre as possibilidades testadas, o modelo utilizado ao final pode ser observado na Figura 3.

Figura 3: Arquitetura final de servidores. Diagrama elaborado pelo autor. Observa-se que os campos denotados Entrada de expressões faciais indicam um computador com uma câmera, realizando a detecção de expressões faciais. Os servidores locais indicam um computador especializado para tratar o roteamento de dados.

Pode-se observar que para um determinado local, um campus da UFABC, por exemplo, pode ser montado um servidor local para compilar as expressões faciais e enviá-las à base de dados, assim como para hospedar a interface gráfica utilizada pelos professores.

Nota-se que também é possível, uma vez que um servidor seja montado em cada um dos Campi da faculdade, o professor do Campus de São Bernardo monitorar as expressões faciais de alunos em Santo André, uma vez que os servidores são interconectados pela base de dados.

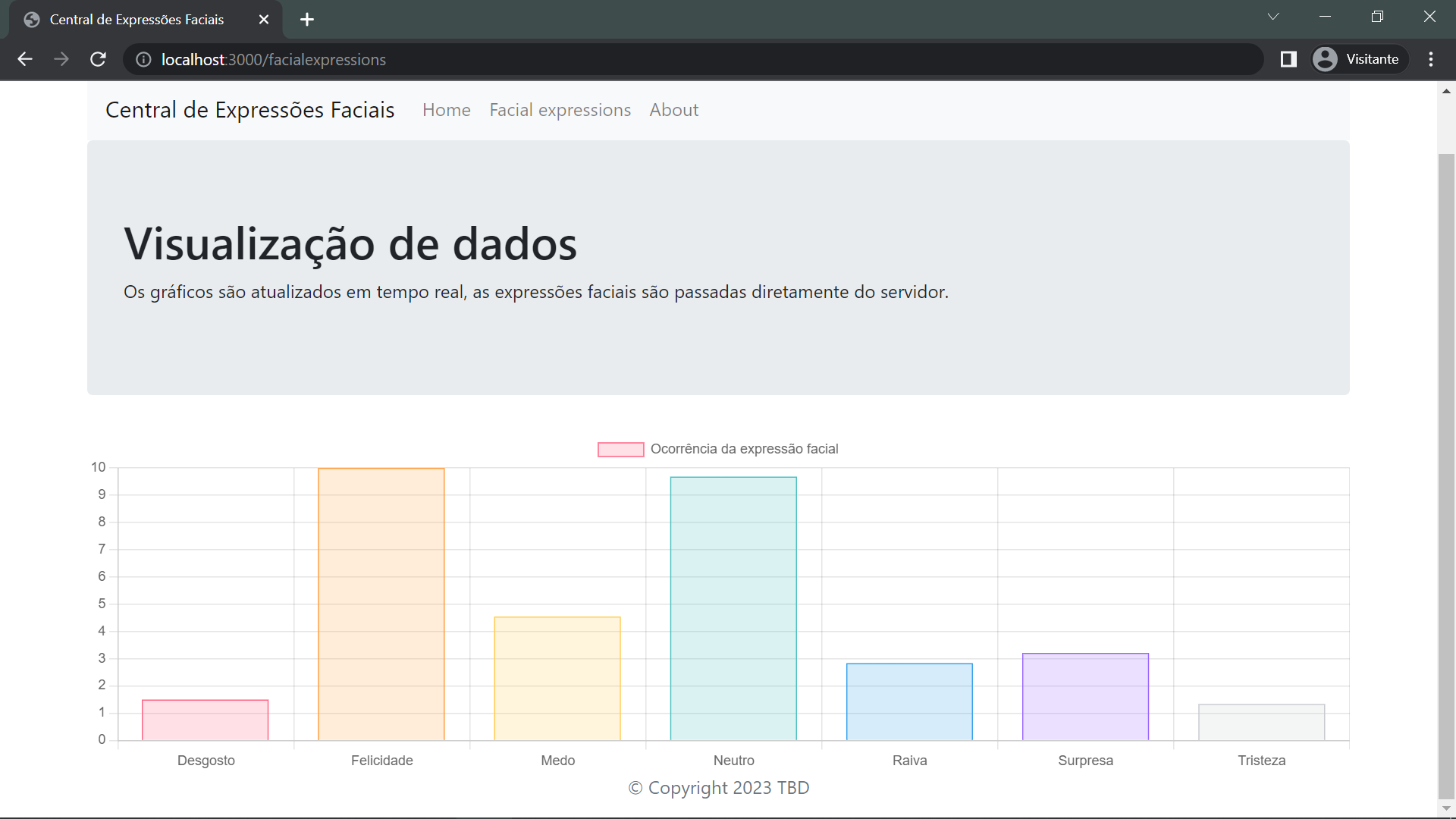

Interface gráfica

Uma interface gráfica web foi desenvolvida para que o professor possa acompanhar as expressões faciais dos alunos por meio de um navegador de internet. Ao acessar o servidor que hospeda a base de dados, as informações são exibidas na interface gráfica que pode ser observada na Figura 4.

Figura 4: Interface gráfica para visualização das expressões faciais. Na captura de tela, pode-se observar um gráfico em barra que é atualizado em tempo real conforme são detectadas novas expressões faciais dos alunos. Captura de tela realizada pelo autor.

Conclusão

Após a validação de viabilidade técnica através das métricas de acurácia e tempo de processamento, as próximas etapas necessárias para a evolução do projeto são testar o sistema com usuários humanos, assim como em ambientes de ensino remotos, efetivamente validando o funcionamento do projeto em campo.

Referências

- Ribeiro, D. & Wells, A. Com pandemia, demanda por videoconferências dispara em empresas brasileiras. CNN Brasil https://www.cnnbrasil.com.br/tecnologia/com-pandemia-demanda-por-videoconferencias-dispara-em-empresas-brasileiras/ (2020)

- Vieceli, L. Número de pessoas que trabalham em casa cresce mais de 50% após pandemia. Folha de S.Paulo https://www1.folha.uol.com.br/mercado/2023/09/numero-de-pessoas-que-trabalham-em-casa-cresce-mais-de-50-apos-pandemia.shtml (2023).

- Khlaif, Z. N., Salha, S. & Bochra Kouraichi. Emergency remote learning during COVID-19 crisis: Students’ engagement. Education and Information Technologies 26, 7033–7055 (2021).

- Pixabay. Pixabay.com https://pixabay.com/photos/ (2024).

- Home. OpenCV https://opencv.org/ (2024).

- davisking. GitHub - davisking/dlib: A toolkit for making real world machine learning and data analysis applications in C++. GitHub https://github.com/davisking/dlib (2024).

- Pham, L., Vu, T. H. & Tran, T. A. Facial Expression Recognition Using Residual Masking Network. (2021) doi:https://doi.org/10.1109/icpr48806.2021.9411919.

- serengil. GitHub - serengil/deepface: A Lightweight Face Recognition and Facial Attribute Analysis (Age, Gender, Emotion and Race) Library for Python. GitHub https://github.com/serengil/deepface (2024).

- Raspberry Pi Ltd. Buy a Raspberry Pi 4 Model B – Raspberry Pi. Raspberry Pi https://www.raspberrypi.com/products/raspberry-pi-4-model-b/ (2024).

- Lucey, P. et al. The Extended Cohn-Kanade Dataset (CK+): A complete dataset for action unit and emotion-specified expression. IEEE Computer Society Conference on Computer Vision and Pattern Recognition workshops (2010) doi:https://doi.org/10.1109/cvprw.2010.5543262.

- Mollahosseini, A., Hasani, B. & Mahoor, M. H. AffectNet: A Database for Facial Expression, Valence, and Arousal Computing in the Wild. IEEE Transactions on Affective Computing 10, 18–31 (2017).

- Li, S. & Deng, W. Deep Facial Expression Recognition: A Survey. IEEE Transactions on Affective Computing 13, 1195–1215 (2022).

Redes Sociais